Imagem: Ensigame.com  A arquitetura inovadora da DeepSeek V3 contribui para sua eficiência. As principais tecnologias incluem previsão de vários toques (MTP) para previsão simultânea de palavras, mistura de especialistas (MOE) utilizando 256 <🎵 🎵> s e atenção latente de várias cabeças (MLA) para foco aprimorado nos elementos cruciais da frase.

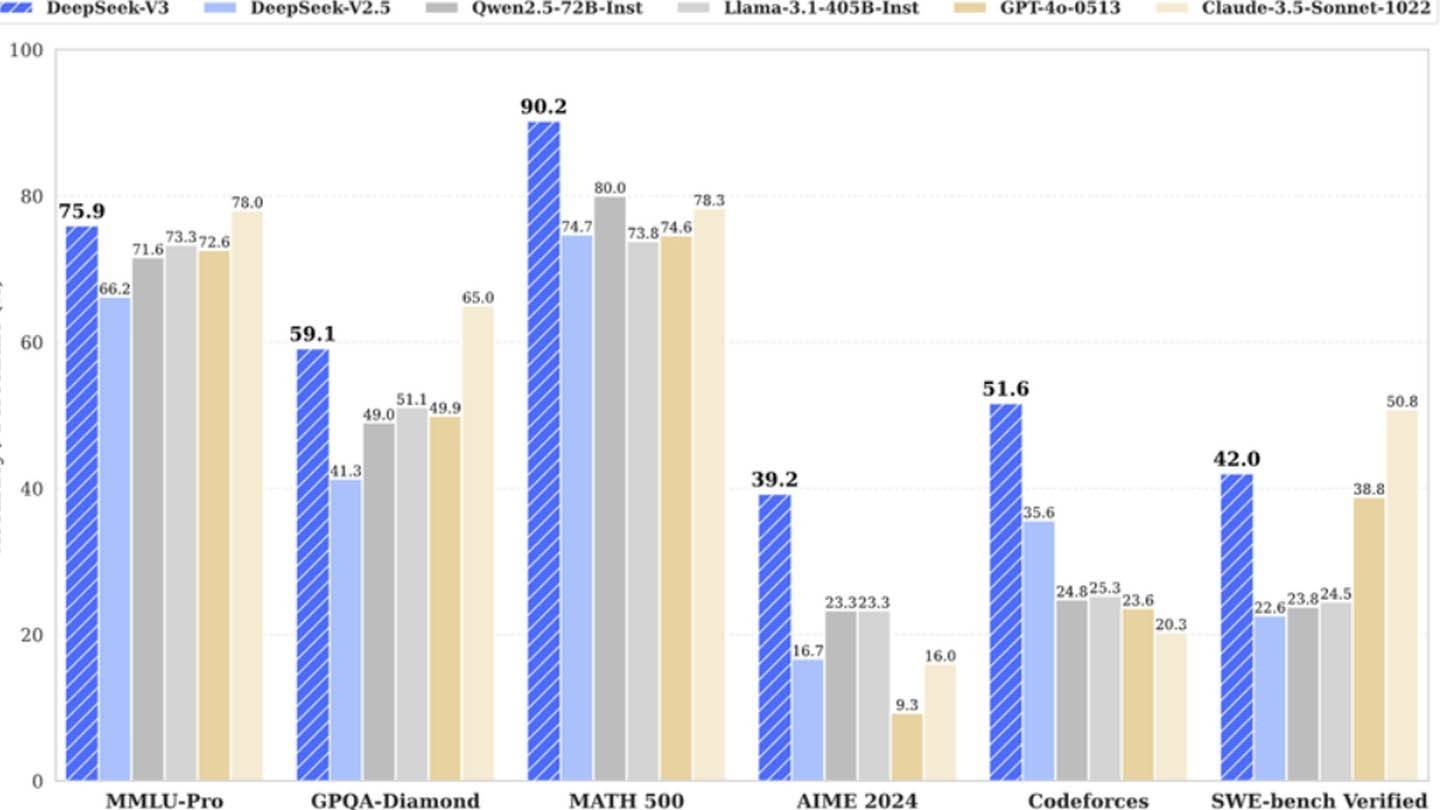

A arquitetura inovadora da DeepSeek V3 contribui para sua eficiência. As principais tecnologias incluem previsão de vários toques (MTP) para previsão simultânea de palavras, mistura de especialistas (MOE) utilizando 256 <🎵 🎵> s e atenção latente de várias cabeças (MLA) para foco aprimorado nos elementos cruciais da frase.

Imagem: Ensigame.com

No entanto, um visual mais próximo revela um investimento substancial de infraestrutura. A análise semiárica descobriu o uso da Deepseek de aproximadamente 50.000 GPUs da NVIDIA Hopper, totalizando cerca de US $ 1,6 bilhão em custos do servidor e US $ 944 milhões em despesas operacionais. Isso contrasta acentuadamente com a reivindicação inicial de custo de treinamento de US $ 6 milhões, que é responsável apenas pelo uso de GPU pré-treinamento, excluindo pesquisas, refinamento, processamento de dados e infraestrutura geral.

<🎵 🎵> O sucesso da Deepseek decorre de sua estrutura independente, permitindo inovação rápida e alocação de recursos eficientes. A empresa, uma subsidiária do High-Flyer Hedge Fund, possui seus data centers, diferentemente dos concorrentes dependentes da nuvem. Além disso, seus altos salários atraem os melhores talentos das universidades chinesas. O investimento total da Deepseek no desenvolvimento da IA excede US $ 500 milhões.

Imagem: Ensigame.com

Imagem: Ensigame.com